2023.02.22.수요일

1. 분산 표현

단어 자체를 벡터화하는 방법을 살펴보겠습니다.

Word2Vec에서 벡터화하려는 대상 단어의 표현입니다.

그것은 주변의 말에 의해 결정됩니다.

이렇게 단어 벡터를 선택한 이유는 분포가설 때문입니다.

“비슷한 위치에 있는 단어는 비슷한 의미를 가집니다”

내가 찾았다 좋은 백화점.

내가 찾았다 멋진 백화점.

두 문장으로 좋은수업 멋진단어 주변에 분포된 단어가 유사하기 때문에,

유사한 의미를 가질 것이라고 가정하는 것이 분포 가설입니다.

이 분포가설을 바탕으로 인접단어의 분포를 바탕으로,

단어의 벡터 표현이 결정되기 때문에 분산 표현호출됩니다

1) 원-핫 인코딩

원-핫 코딩은 범주형 변수를 벡터로 표현하는 방법입니다.

이해하기 쉬운 직관적인 방법입니다. 치명적 오류있다

단어 간의 유사성을 직접 측정하는 것은 불가능합니다.이것은

원-핫 인코딩이 적용된 서로 다른 두 벡터의 내적은 항상 0이므로,

임의의 두 단어를 선택하여 코사인 유사도를 찾아도 값은 0입니다.

이와 같이 원-핫 코딩의 가장 큰 단점은 두 단어의 관계를 절대 알 수 없다는 것입니다.오전.

2) 임베딩

원-핫 인코딩의 단점을 해결한 것 같았습니다. 임베딩그만큼모두.

단어를 고정 길이 벡터, 즉 일정한 차원을 가진 벡터로 나타내기 때문에 “임베딩”이라고 합니다.

임베딩된 워드 벡터는 원-핫 인코딩과 다른 형태의 값을 갖는다.

2. 워드투벡

2013년에 발명됨 워드투벡 문자 그대로 단어를 벡터로 표현하는 방법~에서

가장 널리 사용되는 삽입 방법 중 하나입니다.

워드투벡두 단어(창 크기 = 2) 관계를 사용하여

분포 가설의 좋은 반영~에 있다

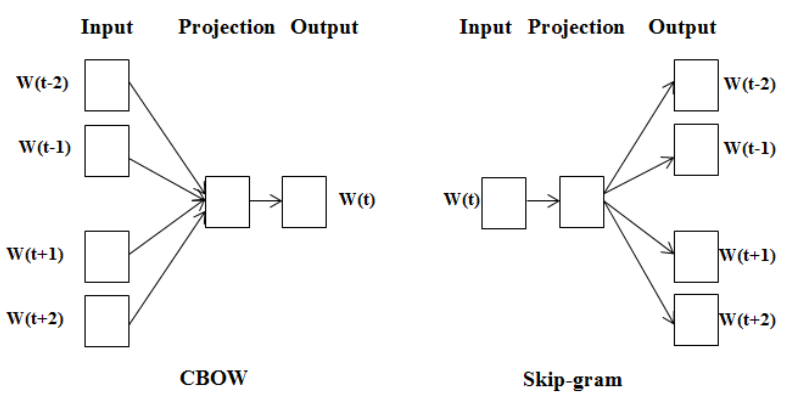

1) CBoW와 스킵그램

- 주변 단어 정보를 기반으로 중심 단어 정보를 예측하는 모델인가요?

연속 워드 백(CBoW) - 중심 단어의 정보를 기반으로 주변 단어의 정보를 예측하는 모델인가요?

스킵 그램

더 많은 정보를 기반으로 특정 단어를 예측하기 때문에

CBoW의 성능이 더 좋을 것이라고 생각하기 쉽지만

따라서 역전파 관점에서 스킵 그램에서 훨씬 더 많은 학습이 일어나고 있습니다.

skip-gram의 성능이 조금 더 좋은 것 같습니다.

계산 노력이 크기 때문에 Skip-Gram은 당연히 더 많은 리소스가 필요합니다.

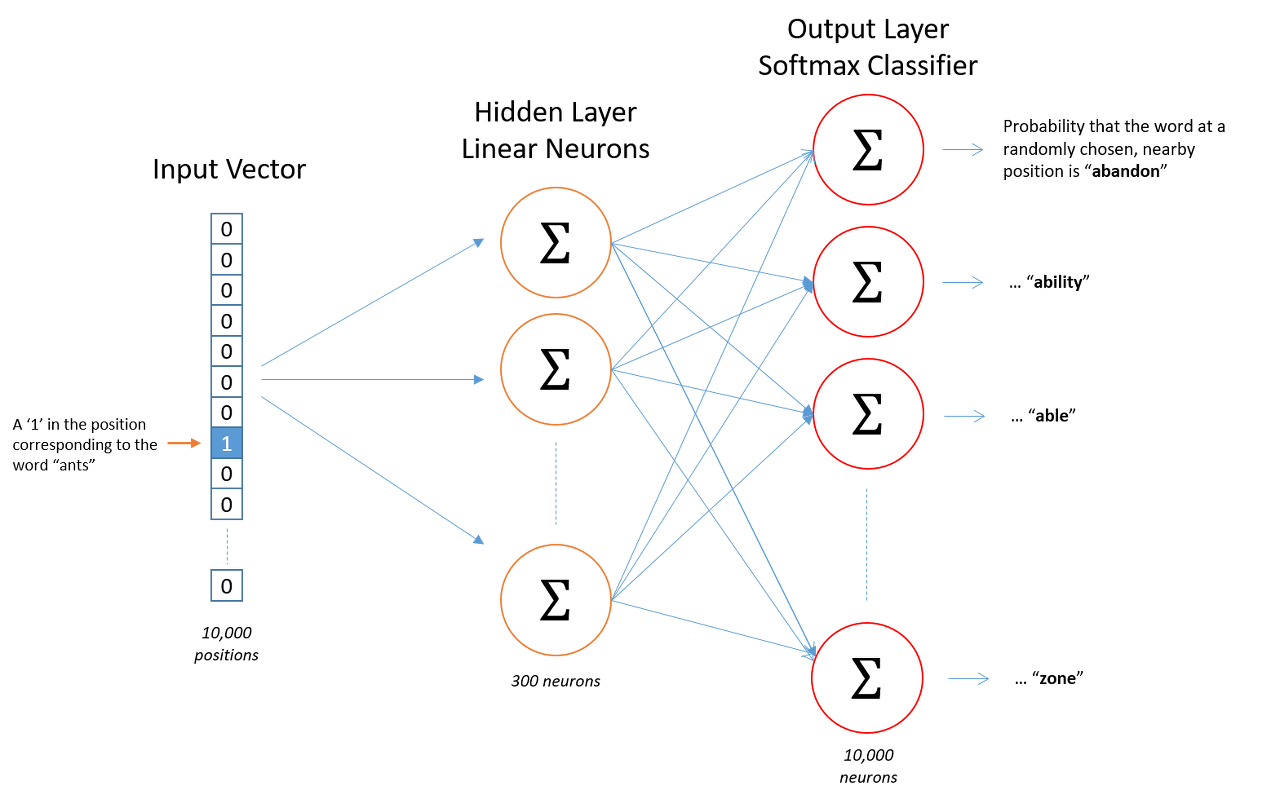

2) Word2Vec 모델의 구조

성능 때문에 좀 더 자주 사용되는 Skip-gram 기반의 Word2Vec 구조를 살펴보자.

- 입력: Word2Vec의 입력은 원-핫 인코딩된 단어 벡터입니다.

- 숨겨진 레이어: 임베딩 벡터의 차원 수만큼 많은 노드로 구성된 숨겨진 레이어가 있는 신경망입니다.

- 출력 레이어: 단어 수만큼의 노드로 구성되며 Softmax를 활성화 함수로 사용합니다.

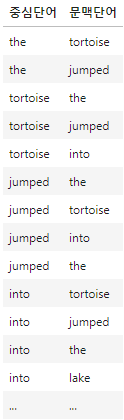

3) Word2Vec 학습을 위한 학습 데이터 설계

효율적인 Word2Vec 학습을 위해서는 훈련 데이터를 잘 정리해야 합니다.

Word2Vec의 창 크기는 2이므로 중심 단어 옆에 있는 두 단어에 대해 단어 쌍이 형성됩니다.

예를 들어, “거북이가 호수에 뛰어들었어요” 문장의 단어 쌍을 구성해 봅시다.

윈도우 크기가 2일 때 다음과 같이 스킵그램 학습을 위한 데이터 쌍을 구성할 수 있습니다.

- 중간 단어: 그만큼주변 문맥 단어: 거북이, 점프

- 훈련 예시: (죽음, 거북이), (죽음, 점프)

- 중간 단어: 남생이주변 문맥 단어: the, jumped, into

- 훈련 예시: (turtle that), (turtle, jumped), (turtle, in)

- 중간 단어: 뛰어 올랐다주변 문맥 단어: the, turtle, in, the

- 학습 예시: (점프, 저것), (점프, 거북이), (점프, 안으로), (점프, 저것)

- 중간 단어: ~에주변 문맥 단어: 거북이, 점프한, the, 호수

- 훈련 예시: (in, turtle), (in, jumped), (in, den), (in, lake)

4) Word2Vec 결과

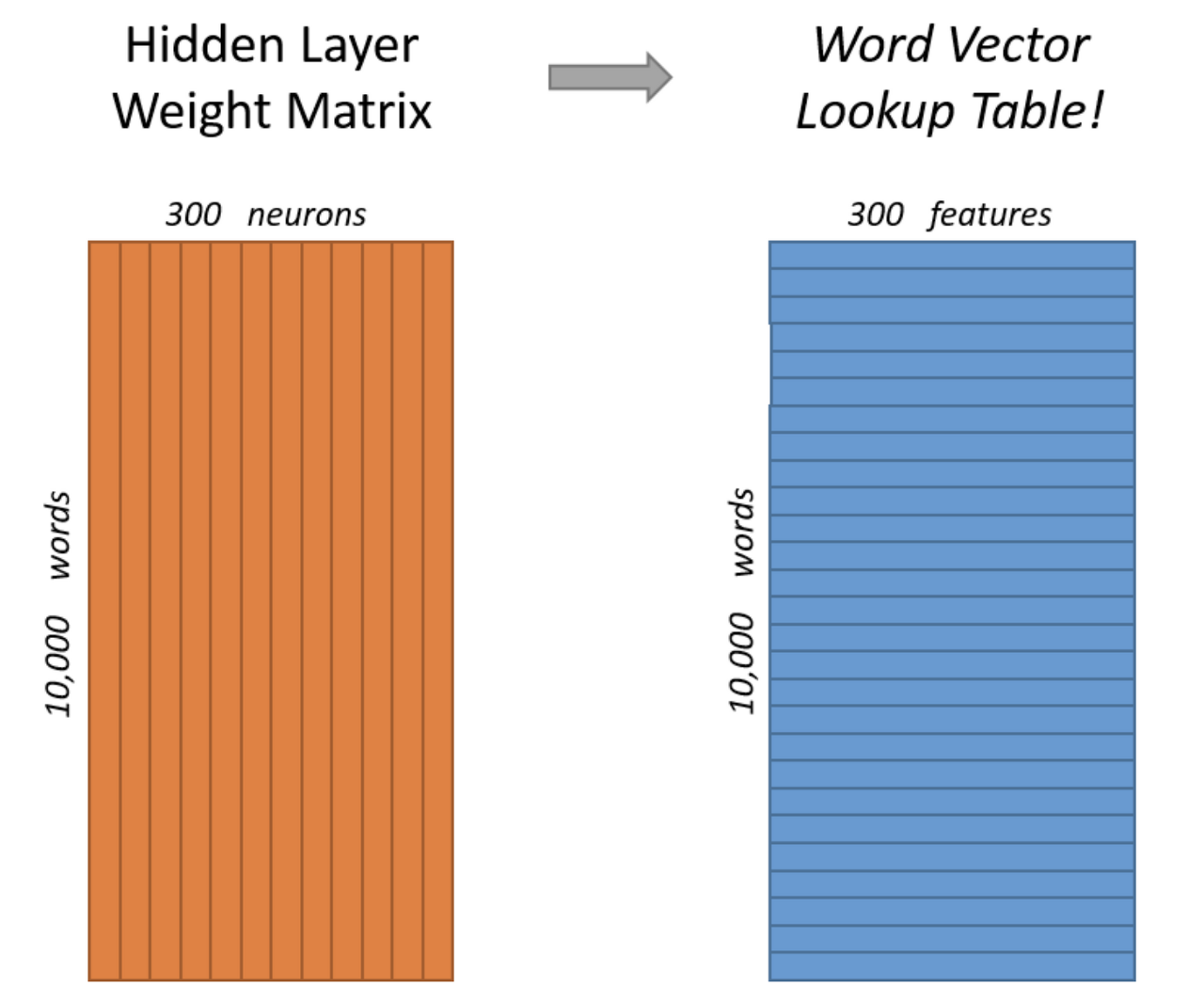

학습이 완료되면 10000단어에 대한 300차원 임베딩 벡터가 생성됩니다.

임베딩 벡터의 차원을 조정하려면 은닉층의 노드 수를 줄이거나 늘릴 수 있습니다.

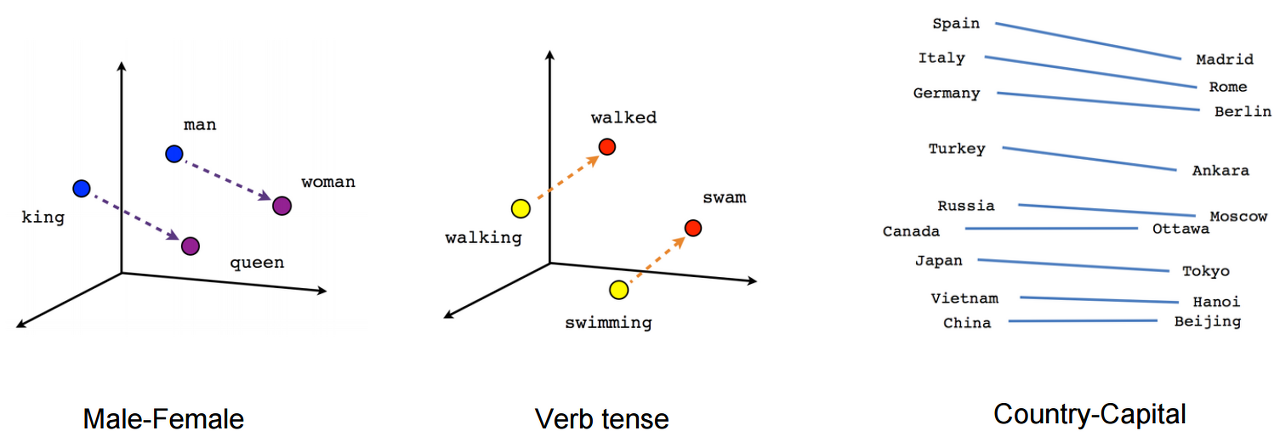

5) Word2Vec에 포함된 벡터 시각화

Word2Vec에서 얻은 임베딩 벡터는 다음과 같습니다. 단어 사이의 의미론적, 문법적 관계를 잘 보여줍니다.

- 남자 여자 와 사이의 관계 왕 여왕 그들 사이의 관계는 매우 유사한 것 같습니다.

생성된 임베딩 벡터는 의미론적 관계를 잘 표현확인할 수 있습니다

- 갔다 – 갔다 와 사이의 관계 수영 – 수영 그들 사이의 관계는 매우 유사한 것 같습니다.

생성된 임베딩 벡터는 문법적(또는 구조적, 구문적) 관계를 잘 표현함확인할 수 있습니다

- 고유명사의 경우 국가-수도와 같은 관계가 잘 표현되어 있음을 확인할 수 있다.